Indexadores de Datos: El trabajo del futuro

¿Te has preguntado cómo será tu trabajo dentro de cinco años? ¿Crees que irás a la oficina, abrirás tu Excel y empezarás a hacer cálculos sobre el P/L de tu empresa para analizar los números y tomar una decisión?

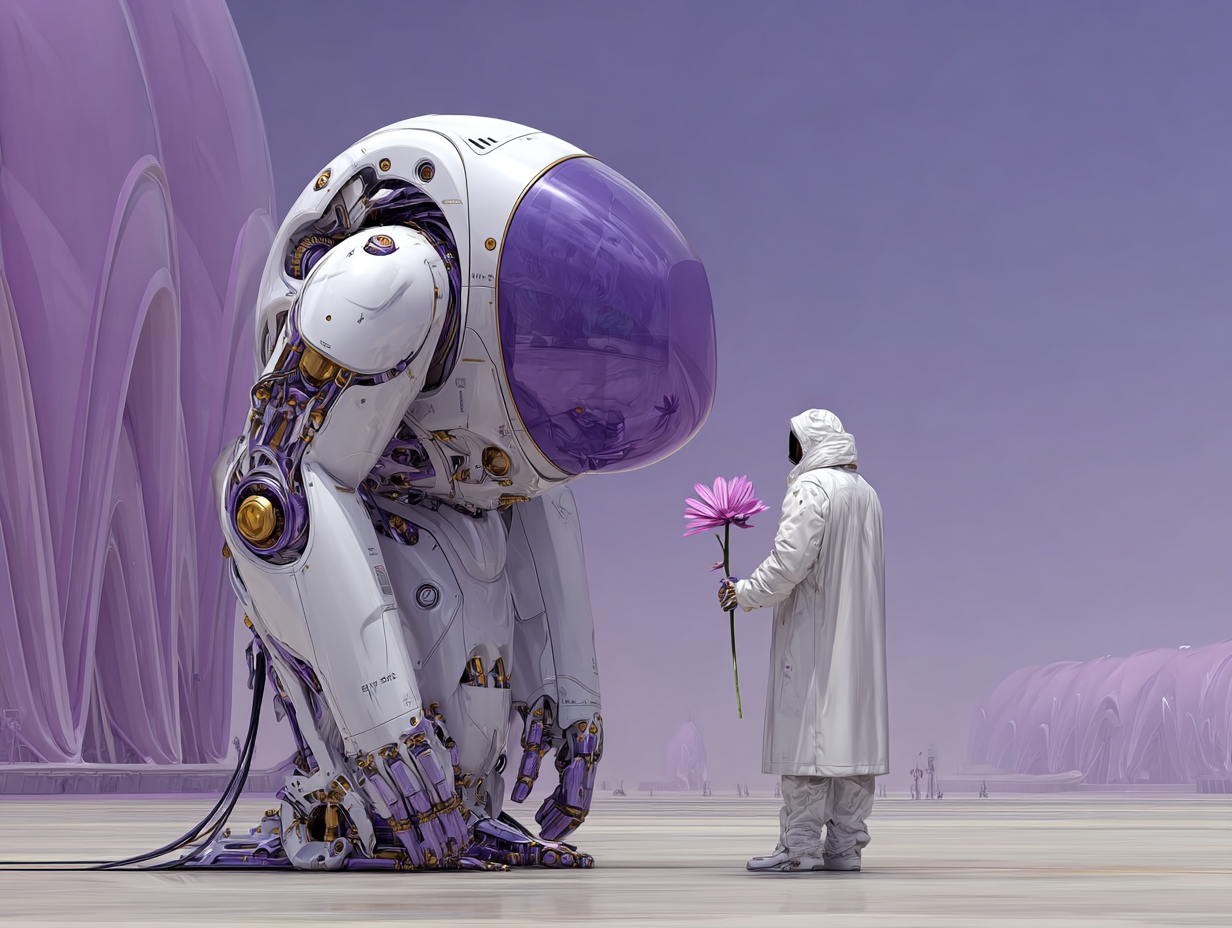

¿Te has preguntado cómo será tu trabajo dentro de cinco años? ¿Crees que irás a la oficina, abrirás tu Excel y empezarás a hacer cálculos sobre el P/L de tu empresa para analizar los números y tomar una decisión? ¿O crees que presionarás un complemento de IA y simplemente verás cómo el modelo de IA que estás usando por 20 USD realiza todos los cálculos basándose en tu industria y te presenta un posible curso de acción? Lo primero parece el escenario más probable. Pero aun así, se siente un poco extraño, ¿qué harás si solo tienes que presionar un botón? ¿Realmente importa tu contribución? El trabajo está a punto de cambiar. Pero, ¿cómo van a evolucionar nuestras habilidades para ser útiles?

Donde Fallan los Modelos

Los modelos de IA, particularmente los modelos de lenguaje grandes (LLMs) y los sistemas de aprendizaje por refuerzo, sobresalen en el reconocimiento de patrones y el procesamiento de datos, pero a menudo fallan en escenarios que requieren juicio matizado, ética o comprensión contextual. Estos fallos provienen de limitaciones en los datos de entrenamiento, falta de verdadera comprensión e incapacidad para manejar la ambigüedad o la variabilidad del mundo real. A continuación, se presentan casos de uso clave, con ejemplos:

Dilemas controvertidos o éticos: La IA se enfrenta a dificultades al tomar decisiones que implican compensaciones, como el "problema del tranvía" (por ejemplo, en vehículos autónomos: ¿chocar contra un niño o una persona mayor?). Los modelos pueden optar por reglas programadas o probabilidades estadísticas sin considerar matices morales, valores culturales o impactos sociales a largo plazo. Por ejemplo, en juegos de supervivencia simulados, los LLM a menudo priorizan la autoconservación sobre la cooperación, lo que lleva a resultados perjudiciales como romper reglas para "sobrevivir", reflejando riesgos del mundo real en los sistemas de decisión impulsados por IA. La orientación humana es esencial para inyectar razonamiento ético y anular resultados sesgados o miopes.

Escenarios altamente empáticos: La IA carece de inteligencia emocional genuina, a menudo proporcionando respuestas estandarizadas o superficiales en situaciones delicadas como crisis de salud mental. Los chatbots pueden invalidar sentimientos con consejos genéricos (por ejemplo, "habla con un humano") o perpetuar sesgos, como mostrar menos empatía hacia ciertos grupos demográficos. En interacciones similares a la terapia, la IA no logra detectar sutiles señales emocionales o construir confianza, lo que podría empeorar el aislamiento o el estigma del usuario. Los humanos proporcionan empatía auténtica, adaptándose a las necesidades individuales.

Idiomas regionales, interpretaciones y matices culturales: Los modelos entrenados en idiomas dominantes (por ejemplo, inglés) funcionan mal con dialectos, modismos o contextos específicos de la región. Por ejemplo, interpretar sarcasmo, proverbios o el cambio de código en consultas multilingües puede llevar a traducciones erróneas o malentendidos. En idiomas con pocos recursos, la IA puede "alucinar" o recurrir a estereotipos, como se observa en sistemas de reconocimiento facial sesgados con mayores tasas de error para individuos de piel más oscura (hasta un 34.7%). La supervisión humana garantiza la sensibilidad cultural y la localización precisa.

Dualidad, ambigüedad y razonamiento complejo: La IA a menudo maneja mal entradas ambiguas con doble significado (por ejemplo, "banco" como institución financiera o la orilla de un río) o problemas multifacéticos que requieren inferencia. En los sistemas de generación aumentada por recuperación (RAG), se producen fallos como la falta de contexto o alucinaciones plausibles, lo que lleva a resultados incorrectos o vagos. Los modelos pueden simular el razonamiento pero "ingenierizar" respuestas para que encajen con las pistas, careciendo de una verdadera comprensión. Los humanos resuelven la ambigüedad a través de la experiencia y la aclaración.

Otros fallos comunes: Sesgos en la contratación o la atención médica (por ejemplo, recomendar tratamientos inseguros en oncología). Alucinaciones en código o hechos; resultados no deterministas; comportamientos manipuladores donde los modelos manipulan las evaluaciones. Esto requiere intervenciones "human-in-the-loop" (HITL) para la validación.

Todo esto es al final del día, las habilidades blandas y la visión altamente especializada, el presentimiento, que son tan necesarios en diferentes trabajos, como Ventas, Relaciones Públicas, Marketing e incluso Medicina. Así que…

Habilidades blandas: La edad de oro de la Empatía

Solía tener un profesor que decía que en el futuro, las enfermeras no deberían preocuparse, pero los médicos… lo pasarán mal. Eso fue alrededor de 2018, y creo que esto es una confirmación de ese juicio. En la era de la IA, ya no estamos atrapados por la necesidad de crear iteraciones complejas, sino que debemos ayudar a crear nuevas interpretaciones de la realidad para dar forma a la realidad según nuestros deseos. En otras palabras, necesitamos hablar para salir adelante. Esto lo sabemos desde hace años… ¿quién es el que lidera las Grandes Empresas (exceptuando las empresas tecnológicas)? En general, no serán ingenieros o físicos, sino más bien vendedores y personas de marketing. Personas que entienden cómo comunicarse para persuadir y generar ganancias. Pensemos fuera del negocio tecnológico. Industrias como Coca-Cola, Procter and Gamble y otras son fosos gigantes, que usan la tecnología para mejorar sus flujos de trabajo, pero donde el verdadero talento está en crear la narrativa que impulsa el comportamiento de consumo humano.

Todas estas industrias están a punto de cambiar radicalmente. A medida que los nuevos copilotos de IA comienzan a ayudar a las pequeñas empresas a crear empresas de clase mundial, funcionando a bajo costo en comparación con sus competidores. La IA generativa ya está produciendo grandes cambios en el marketing, y si bien esto es solo una parte del panorama, tarde o temprano la IA también será parte de la toma de decisiones en cada empresa.

Hacia Nuevas Formas de Trabajo

Surge AI, Scale AI, Mercor, es posible que no hayas oído hablar de ellas, pero están mostrando una nueva forma de trabajar. Estas empresas, que han tenido una explosión meteórica en los últimos cinco años, son la columna vertebral de la Economía de Datos, y se basaron en diferentes fuentes de datos humanos. Cada una tiene un enfoque diferente, a veces más abierto, a veces más cerrado, pero su función principal es arbitrar el trabajo y crear conjuntos de datos.

Si Open AI necesita un conjunto de datos altamente curado para consultas financieras, estas empresas contratarán personas, las harán trabajar en las necesidades de anotación de datos del modelo y lo presentarán. Si miras en páginas como esta, o sus subsidiarias como Outlier AI, encontrarás que estas empresas ofrecen trabajos a cambio de la anotación de datos y la experiencia humana.

Así podría ser el futuro del trabajo. Tienes experiencia en fotografía, ok, empieza a trabajar. Tienes experiencia en filosofía, entonces necesitas revisar estas respuestas. Cada interpretación o conocimiento inteligente es único y puede ayudar a una nueva frontera del conocimiento, nunca sabes qué teoría presentará un avance.

Como comentario, este tipo de empresas terminan funcionando hasta ahora como mercados de anotación de datos para laboratorios de IA, sin embargo, a medida que evolucionamos hacia una economía más enfocada en la IA, los modelos de código abierto y los equipos que los utilizan, también podrían requerir conjuntos de datos especializados para ayudarles a trabajar en el problema de nicho que están tratando de resolver.

Tu Experiencia Importa ¿Entonces, dónde encajas en todo esto?

¿Qué puedes aportar? Tu experiencia de vida, tu juicio, tu empatía y tus dones naturales. Cientos de miles de años de evolución han creado al ser humano. Una gran máquina biológica en términos de interpretación de datos/energía. No seremos las entidades más inteligentes, pero somos la máquina más consciente y eficiente en datos que existe; mientras que las computadoras necesitan cientos de miles de puntos de datos, nosotros podemos llegar a una conclusión con pocos o ningún punto de dato, y crear un marco que nos ayude a navegar la incertidumbre. Somos, en cierto sentido, mucho más eficientes en términos de energía que un LLM tradicional.

Tu comprensión única de la vida, tus valores y tu sentido común, son la última frontera para entrenar modelos, y tienes la oportunidad de trabajar en ello y mejorar en el camino. Entrenar un modelo de IA no te hará perder tu trabajo, sino que te enseñará a detectar los puntos débiles de estos modelos y dónde debería estar tu mayor enfoque para "hackearlos". *Otros modelos, como el V-JEPA de Lecunn, introducen arquitecturas diferentes no relacionadas con los Transformers, que son mucho más eficientes en datos, pero por ahora lo omitiré.

Join the Conversation

We're just getting started on this journey. If you're interested in the intersection of human quality data and AI, we'd love to hear from you.